什么是逻辑斯谛回归模型?

- 逻辑斯谛回归是统计学习中的经典分类方法,在这个模型中,我们试图找到一个函数,该函数能够将输入数据映射到一个介于 0 和 1 之间的概率值,表示某个样本属于正类的概率。然后,我们可以通过设定一个阈值(例如 0.5)来判断样本的类别

- 例子:假设你是一名银行工作人员,需要评估客户是否会违约(即不按时还款)。你有一份包含客户信息的数据集,其中每个客户都有两个特征:年收入(income)和负债率(debt_ratio)。你想要根据这些信息预测客户是否会违约。

- 逻辑斯谛回归模型与最大熵模型都属于对数线性模型

什么是二项逻辑斯谛回归模型?

- 二项逻辑斯谛回归模型是一种分类模型,由条件概率分布 P (Y|X) 表示,形式为参数化的逻辑斯谛分布。这里,随机变量 X 取值为实数,随机变量 Y 取值为 1 或 0 。我们通过监督学习的方法来估计模型参数。

- 在逻辑斯谛回归模型中,输出 Y = 1 的对数几率是输入 x 的线性函数。或者说,输出 Y = 1 的对数几率是由输入 x 的线性函数表示的模型,即逻辑斯谛回归模

log1−P(Y=1∣x)P(Y=1∣x)=w⋅x

什么是多项逻辑斯谛回归模型?

- 将二项逻辑斯谛回归模型推广为多项逻辑斯谛回归模型,用于多类分类。假设离散型随机变量 Y 的取值集合是 {1,2,…, K},模

P(Y=k∣x)P(Y=K∣x)=1+∑k=1K−1exp(wk∙x)exp(wk∙x),k=1,2,⋯,K−1=1+∑k=1K−1exp(wk∙x)1

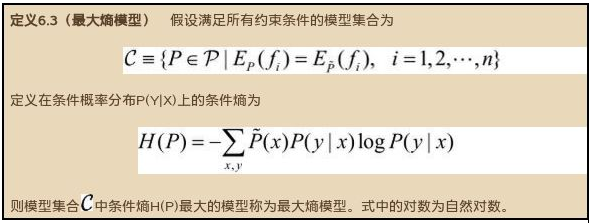

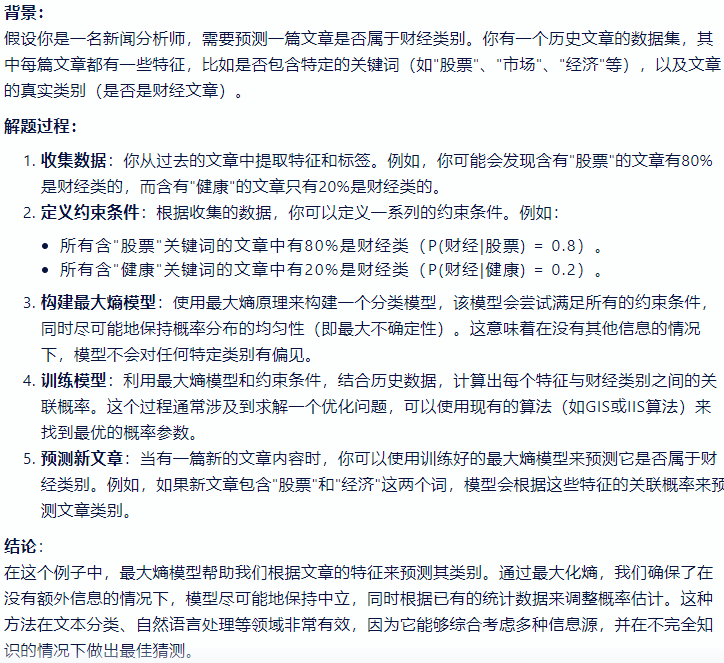

什么是最大熵模型?

![]()

- 最大熵模型是一种基于概率分布的模型,它的核心思想是在满足所有已知约束条件的前提下,选择具有最大不确定性的概率分布 (熵最大)。这种模型在机器学习和自然语言处理等领域有广泛的应用

- 最大熵原理认为要选择的概率模型首先必须满足已有的事实,即约束条件。在没有更多信息的情况下,那些不确定的部分都是 “等可能的”。最大熵原理通过熵的最大化来表示等可能性

![]()

逻辑斯谛回归模型、最大熵模型的优化算法有哪些?

- 逻辑斯谛回归模型、最大熵模型学习归结为以似然函数为目标函数的最优化问题,通常通过迭代算法求解。从最优化的观点看,这时的目标函数具有很好的性质。它是光滑的凸函数,因此多种最优化的方法都适用,保证能找到全局最优解

- 常用的方法有

逻辑回归缺点

- 对于非线性特征,需要转换

- 当特征空间很大时,LR 的性能并不是太好

什么是逻辑回归?

- 其实是一个分类算法而不是回归算法,通常是利用已知的自变量来预测一个离散型因变量的值,简单来说,它就是通过拟合一个逻辑函数来预测一个事件发生的概率,因此非常适合处理二分类问题

- 深层理解:在逻辑回归的推导中,它假设样本服从伯努利分布(0~1 分布),然后求得满足该分布的似然函数,再取对数、求极值等。而逻辑回归并没有求似然函数的极值,而是把极大化当作一种思想,进而推导出它的经验风险函数为:最小化负的似然函数 [maxF(y,f(x))→min-F(y,f(x))]。从损失函数的视角来看,它就成了对数(Log)损失函数了。对数损失函数越小,模型就越好,而且使损失函数尽量是一个凸函数,便于收敛计算

最大熵模型的极大似然估计?

SVM、LR、决策树的对比

- 模型复杂度:SVM 支持核函数,可处理线性非线性问题;LR 模型简单,训练速度快,适合处理线性问题;决策树容易过拟合 (overfitting),需要进行剪枝

- 损失函数:SVM hinge loss; LR L2 正则化;Adaboost 指数损失

- 数据敏感度:SVM 添加容忍度对 outlier 不敏感,只关心支持向量,且需要先做归一化;LR 对远点敏感

- 数据量:数据量大就用 LR,数据量小且特征少就用 SVM 非线性核

Logistic 回归和 SVM 算法有什么区别和联系?

- 相同点

- Logistic 回归和 SVM 都是分类算法

- 如果不考虑使用核函数,LR 和 SVM 都是线性分类模型,也就是说它们的分类决策面是线性的

- 都是有监督学习的算法

- LR 和 SVM 都是判别模型

- 不同点

- 损失函数不同:LR 基于概率理论,通过极大似然估计方法估计出参数的值,然后计算分类概率,取概率较大的作为分类结果。SVM 基于几何间隔最大化,把最大几何间隔面作为最优分类面。 逻辑回归采用的是 Logistical Loss,SVM 采用的是 hinge loss. 这两个损失函数的目的都是增加对分类影响较大的数据点的权重,减少与分类关系较小的数据点的权重

- 使用的样本不同:SVM 只考虑分类面附近的局部的点,即支持向量,LR 则考虑所有的点,与分类面距离较远的点对结果也起作用,虽然作用较小

- 处理非线性问题不同:在解决非线性分类问题时,SVM 采用核函数,而 LR 通常不采用核函数

- 决策函数不同:Logistic 回归是通过 sigmoid 函数来进行分类的,类别分为 {0,1}. SVM 是通过 sign 函数来进行分类的,类别分为 {+1,-1}

- 正则化项:SVM 损失函数自带正则化 (regularization) 项,因此,SVM 是经验风险最小化算法。而 LR 需要额外在损失函数上加正则化 (regularization) 项

- SVM 不具有伸缩不变性,LR 则具有伸缩不变性

- Logic 能做的 SVM 能做,但可能在准确率上有问题,SVM 能做的 Logic 有的做不了

Logistic 回归和 Linear 线性回归有什么区别和联系?

- 逻辑回归和线性回归首先都是广义的线性回归

- 优化目标:经典线性模型的优化目标函数是最小二乘,而逻辑回归则是似然函数

- 分类范围:线性回归在整个实数域范围内进行预测,敏感度一致,而分类范围,需要在 [0,1]。逻辑回归就是一种减小预测范围,将预测值限定为 [0,1] 间的一种回归模型,因而对于这类问题来说,逻辑回归的鲁棒性比线性回归的要好

什么是对数几率 (log-odds)?

- 某个事件几率的对数。如果事件涉及二元概率,则几率指的是成功概率 (p) 与失败概率 (1-p) 之比

- 简单来说,对数几率即几率的对数。按照惯例,“对数” 指自然对数,但对数的基数其实可以是任何大于 1 的数

![]()

![]()