本文通过拆解 LSTM,并通过统计几个模块的参数量来分析各个模块的原理

1.LSTM 简单介绍

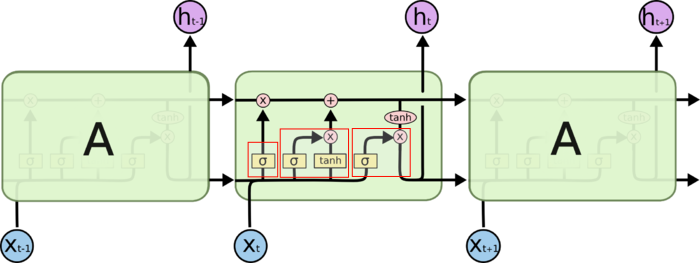

![LSTM在时间上展开]()

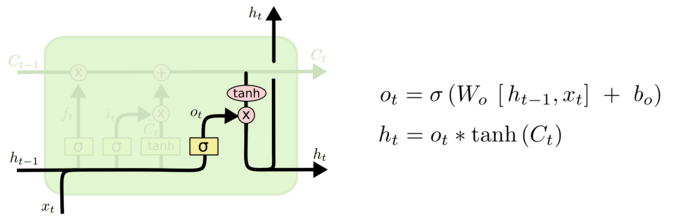

红框从左到右,依次是:

忘记门层: 决定从细胞状态中丢弃什么信息,通过当前时刻输入和前一个时刻输出决定

细胞状态: 确定并更新新信息到当前时刻的细胞状态中

输出门层: 基于目前的细胞状态决定该时刻的输出

2. 简单假设样例

假设现有一个样本,Shape=(13,5), 时间步是 13, 每个时间步的特征长度是 5. 形象点,我把一个样本画了出来:

⎝⎜⎜⎜⎜⎛a11a21⋮a131a12a22⋮a132⋯⋯⋱⋯a15a25⋮a135⎠⎟⎟⎟⎟⎞

使用 Keras 框架添加 LSTM 层时,我的设置是这样的 keras.layers.LSTM(10), 也就是我现在设定,每个时间步经过 LSTM 后,得到的中间隐向量是 10 维 (意思是 5->10 维),13 个时间步的数据进去得到的是 (13*10) 的数据.

每个时间步对应神经元个数 (参数个数) 一样。也就是算一个 LSTM 中神经元个数,算一个时间步中参与的神经元个数即可。下面将对 LSTM 每个计算部分进行神经元分析.

3. 神经元分析

3.1 忘记门层

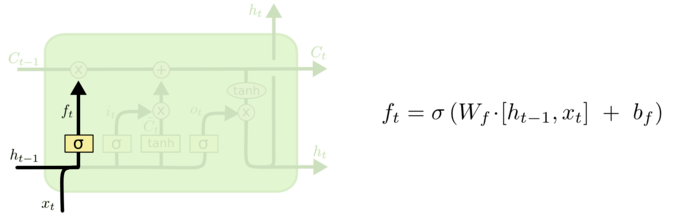

![忘记门层]()

图中公式的 !$h_{t-1}$ 是上一个状态的隐向量 (已设定隐向量长度为 10),!$x_t$ 为当前状态的输入 (长度为 5), 那么 !$[h_{t-1},x_t]$ 的长度就是 10+5=15 了.!$W_f$ 和 !$b_f$ 为该层的参数.

该层输出是中间隐向量的长度 (10), 经过 !$\sigma$ 激活前后的长度不变。只需要考虑 !$\sigma$ 里面的操作得到 10 维特征即可.

!$[h_{t-1},x_t]$ 是 (1,15) 的向量,与 !$W_f$ 相乘得到 (1,10) 的向量,根据矩阵相乘规律,得到 !$W_f$ 是 (15,10) 的矩阵,得到 (1,10) 矩阵后,与该门层偏置相加,偏置也应该有相同的形状,即 !$b_f$ 是 (1,10) 的矩阵.

即:该层神经元为:

Neurons1=15×10+10=160(1)

3.2 细胞状态

(1) 确定更新信息过程

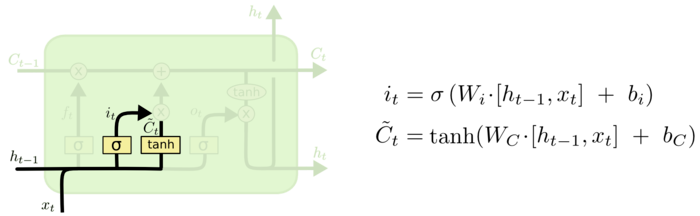

![确定该时刻细胞要更新的内容]()

可以看到,这里公式和前面的一样的,!$\sigma$ 和 !$\tanh$ 都是激活函数,不影响参数个数.

同理这过程的神经元个数是:

Neurons2=2×(15×10+10)=320(2)

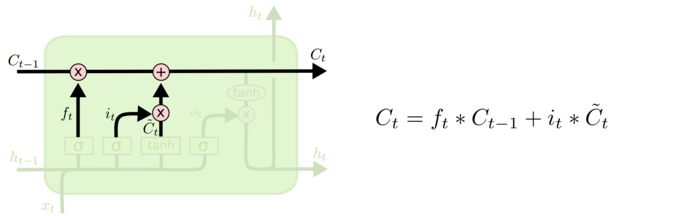

(2) 更新过程

![1613540825378]()

公式中的四个值,均是前面计算得到的结果,因此该过程没有参数需要学习.

3.3 输出层

![1613540825379]()

一样的公式,神经元个数一样。即个数为:

Neurons3=15×10+10=160(3)

3.4 总结

把公式 (1),(2),(3) 的神经元加起来,就是该 LSTM 的神经元个数了.

Neuronsall=Neurons1+Neurons2+Neurons3=160+320+160=640

其实,我们可以把这个问题一般化,不看这个例子,假设你一个时间步的特征长度是 n, 经过该 LSTM 得到的长度是 m #800028, 这样就可以算出该 LSTM 层的神经元个数为:

Neuronsall=4×((n+m)×m+m)

4. 测试

1

2

3

4

5

6

7

8

9

10

| from keras.layers import LSTM

from keras.models import Sequential

time_step=13

featrue=5

hidenfeatrue=10

model=Sequential()

model.add( LSTM(hidenfeatrue,input_shape=(time_step,featrue)))

model.summary()

|

输出是:

1

2

3

4

5

6

7

8

9

10

| _________________________________________________________________________________

Layer (type) Output Shape Param

=================================================================================

lstm_8 (LSTM) (None, 10) 640

=================================================================================

Total params: 640

Trainable params: 640

Non-trainable params: 0

_________________________________________________________________________________

|

参考:

理解 LSTM 网络

推荐给初学 LSTM 或者懂个大概却不完全懂的人