GhostNetV2:Enhance Cheap Operation with Long-Range Attention

GhostNetV2 在 GhostNetV1 的基础上,提出新的注意力机制,用于捕获长距离的空间信息,在精度和推理速度之间获得更好的平衡

什么是 GhostNetv2 ?

![]()

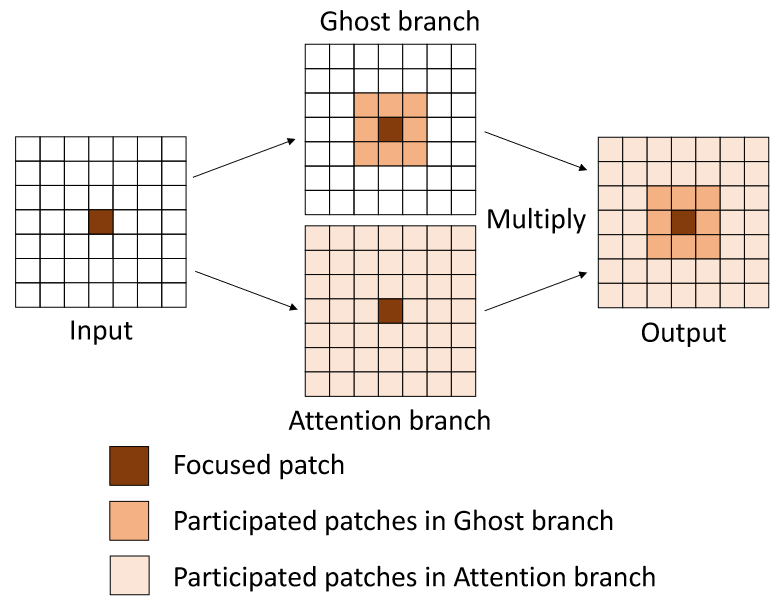

- GhostNetv1 通过将标准卷积分解为 2 个过程,减少了计算量,但是其特征表示能力下降,GhostNetv2 则通过引入注意力来解决

- 如果构建特征的自注意力,需要构建 HWxHW 大小的注意力矩阵,这对轻量化模型是有害的,借鉴 CBAM 的 SAM 模块,直接构建其 HW 大小的空间注意力矩阵,同时为了轻量化,通过分解卷积去构建,最终得到 DFC 注意力构建模块

GhostNetv2 的 G-bootleneck?

![GhostNetv2-20230408140228]()

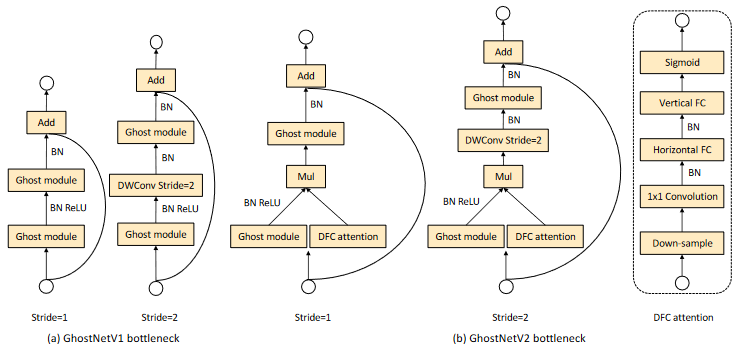

- GhostNetv2 修改了 G-bootleneck,输入特征时,第一个 Ghost Module 变为并行生成特征及特征注意力,注意力加权特征后再给后续模块

GhostNetv2 的 “双解藕密集连接注意力 “模块?

![]()

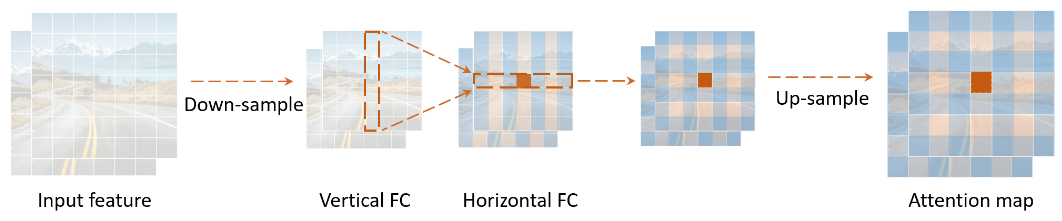

- GhostNetv2 没有直接构建 HWxHW 大小的注意力矩阵,而是依次在水平方向、垂直方向构建注意力,获得全局注意力,其构建注意力的复杂度由 O (HWxHW) 变为

- SE Block:输入 hwc,直接使用 1x1 卷积,生成大小为 hw 的注意力矩阵,c 的每个通道共用这个注意力矩阵

- DFC:输入 hwc,使用分组卷积 + 分解卷积,生成大小为 hwc 的注意力矩阵,每个通道有自己的注意力矩阵

参考资料