ELMO:Deep contextualized word representations

为解决一词多义的问题,ELMO 设定词汇的嵌入不是固定的,而是在不同语境中动态变化的,输入语境及词汇,得到词汇的词向量

什么是 ELMO ?

![]()

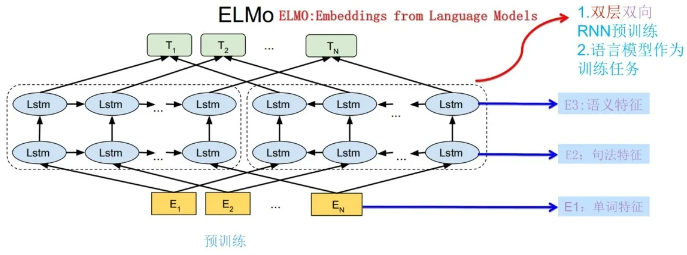

- 传统的词嵌入方法都是一个词赋予一个向量,而我们的词向量是一个整个输入句子的函数(双层双向 LSTM),也就是说 ELMO 会根据词语所在的不同上下文,构建不同的词嵌入(解决一词多义问题)

- ELMO 在大规模预料训练后,可以应用到概念蕴涵、问题回答和情感分析等下游任务,开启了预训练模型 (PLM) 的先河

ELMO 的网络结构?

![]()

- 一个双层双向的 LSTM 模型,预训练时其是自监督学习的,应用到下游时取不同层的 LSTM 使用即可

和 GloVe 相比,ELMO 的特点?

![]()

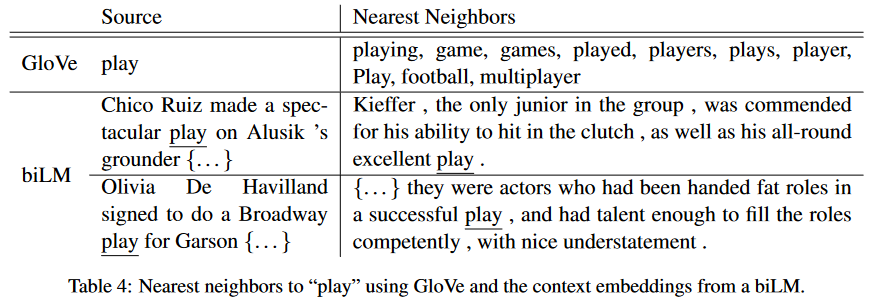

- 表 4 表示两者查询最近词的过程,可以看出 GloVe 是基于共现矩阵,只能得出和 Play 接近的词汇,而 ELMO 是基于语境的,能解决一词多义的问题

参考: