机器学习回归领域通用知识

什么是线性回归?

- 利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛

- 按照输入变量的个数,分为一元回归和多元回归

- 一般来说,线性回归都通过最小二乘法求出其方程,可以计算出对于 y=bx+a 的直线

什么是广义线性回归?

- (1)如果是连续的,就是多重线性回归。

- (2)如果是二项分布,就是逻辑回归。

- (3)如果是泊松分布,就是泊松回归。

- (4)如果是负二项分布,就是负二项回归。

- (5)逻辑回归的因变量可以是二分类的,也可以是多分类的,但是二分类的更为常用,也更加容易解释。所以实际中最常用的就是二分类的逻辑回归

什么是非线性回归?

- 如果回归模型的因变量是自变量的一次以上函数形式,回归规律在图形上表现为形态各异的各种曲线,称为非线性回归

- 常用的处理方法有回归函数的线性迭代法、分段回归法、迭代最小二乘法等

线性回归、逻辑回归、感知机的区别?

- 线性回归是一个回归问题,样本的输出都是连续值

- 逻辑回归是一个二分类问题

- 感知机是一个二分类问题

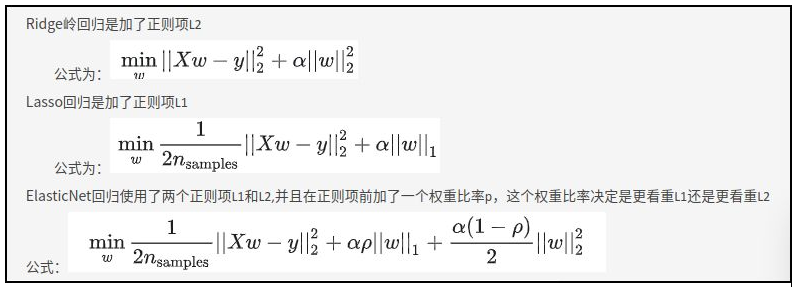

LASSO 回归、Ridge 回归的异同?

- 都是在标准线性回归的基础上修改 cost function 得到,都可以用来解决标准线性回归的过拟合问题

- Lasso 回归可以用来做特征选择,而 Ridge 回归 (岭回归) 不行。或者说,lasso 更容易使得权重变为 0,而 ridge 更容易使得权重接近 0。

- 从贝叶斯角度看,lasso(L1 正则)等价于参数 w 的先验概率分布满足拉普拉斯分布,而 ridge(L2 正则)等价于参数 w 的先验概率分布满足正态分布

- Lasso 回归是在 ridge 回归的基础上发展起来的,如果模型的特征非常多,需要压缩,那么 Lasso 回归是很好的选择。一般的情况下,普通的线性回归模型就够了

正则化(L1、L2)与 Lasso 回归、Ridge 回归的关系?

- Lasso 回归、Ridge 回归是分别在标准化线性回归基础上加上 L1 正则化 、L1 正则化正则项的回归方法

- 以限制回归过程模型参数的解空间,可进行特征选择或避免过拟合 (overfitting)

Logistic 回归和 Linear 线性回归有什么区别和联系?

- 逻辑回归和线性回归首先都是广义线性回归

- 优化目标:经典线性模型的优化目标函数是最小二乘法,而逻辑回归则是似然函数 (likelihoodfunction),

- 分类范围:线性回归在整个实数域范围内进行预测,敏感度一致,而分类范围,需要在 [0,1]。逻辑回归就是一种减小预测范围,将预测值限定为 [0,1] 间的一种回归模型,因而对于这类问题来说,逻辑回归的鲁棒性比线性回归的要好

ElasticNet 回归和 Ridge 岭回归和 Lasso 回归有什么区别?