RAG 的 Generator

通过检索的上下文回答用户的 query

使用思维链消除噪音

通过使用思维链 (CoT) 提示来提高 AI 响应的准确性。这种技术涉及引导您的系统完成一系列逻辑步骤或 “想法”,帮助它专注于相关信息,同时过滤掉噪音。通过遵循思路,您的模型可以更好地了解查询背后的上下文和意图,从而获得更精确和相关的结果

在处理复杂查询时,链式思维提示特别有效,因为 LLM 需要推理才能生成最终响应。像 DSPy 这样的框架特别能够进行 Chain-of-Thought 提示

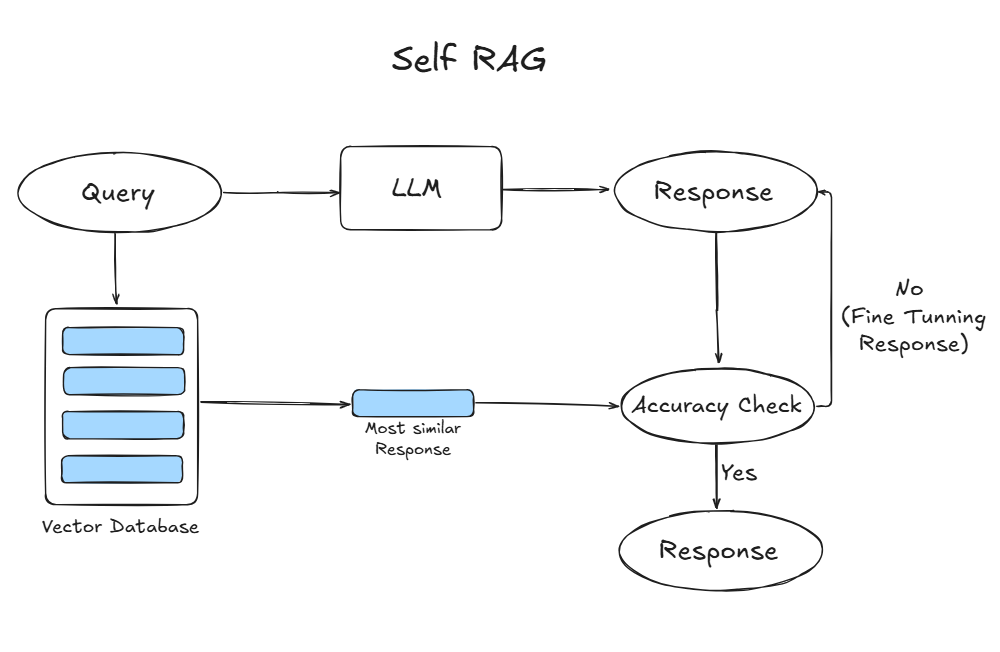

使用 Self-RAG 迭代答案

Self-RAG 是一种高级技术,它使您的系统能够通过迭代其输出来改进自己的检索和生成过程。在 Self-RAG 中,该模型不仅依赖于初始检索,而且通过生成后续查询和响应来主动重新评估和调整其方法。此迭代过程允许模型纠正自己的错误、填补空白并提高最终输出的质量

CoN:通过笔记链增强 RAG 效果

核心思想:不直接从检索到的内容生成回答,而是先让模型对检索到的内容生成阅读笔记,然后再生成最终的回答

langchian 创建增强回答链时,可以设置

MapReduce方式,该方式首先将每个独立的文档单独发送到语言模型以获取原始答案。然后,这些答案通过最终对语言模型的一次调用组合成最终的答案

之所以使用这个方法,增强检索到的内容可以分为三类:

- 相关:检索到的文档可以直接回答问题

- 无关但是有用:无法直接回答问题,但是提供回答的有用信息

- 无关:对回答无帮助

使用该方式能提取出对回答 “相关的” 或者 “有用” 的信息,过滤无关信息

毫无疑问,这个方式相当于利用大模型作了一次检索文档的过滤,能提升检索的准确性,但是会增加耗时,并且对于需要准确检索的提问,经过一次 LLM 总结后,可能被丢失了