LRNNET:A Light-Weighted Network with Efficient Reduced Non-Local Operation for Real-Time Semantic Segmentation

基于 LEDNet 改进,使用 SVD 简化 non-local 网络,通过分解因子卷积块(FCB)扩大感受野,通过 SVN 模块构建稀疏的空间注意力

什么是 LRNNet?

![LRNNet-20230408152301]()

- 基于 LEDNet 改进,使用 SVD 简化 non-local 网络,通过分解因子卷积块(FCB),扩大感受野

- 通过非局部模块(SVN),利用区域奇异向量产生更有代表性的特征来建模远程依赖和全局特征选择

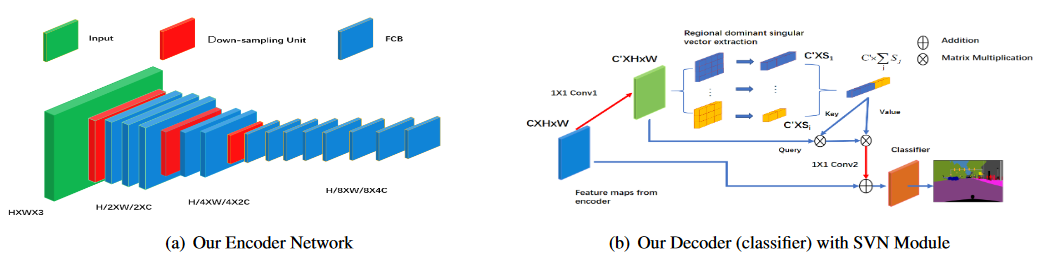

LRNNet 的网络结构?

![LRNNet-20230408152301]()

- 编码器:三个阶段的 ResNet 形式组成。编码器环节的核心组件是分解因子卷积 FCB 单元,同时在最后一个下采样单元之后,采用了空洞卷积上输出特征图的分辨率保持在 1/8

- 解码器:包含 2 层分支,其中下层分支是输入的残差,上层分支是非局部模块(SVN),它利用区域奇异向量产生更有代表性的特征来建模远程依赖和全局特征选择

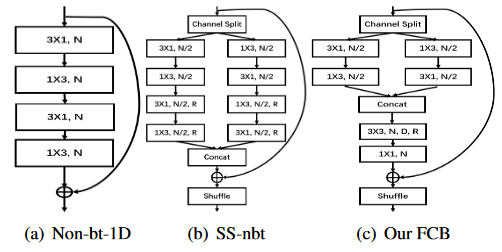

LRNNet 的 FCB(Factorized Convolution Block)模块?

![HMANet-20230408143223]()

- 首先将通道拆分成两组,然后在两组通道中分别用两个一维卷积处理短距离和空间较少的信息特征,这样会大大降低参数和计算量。

- 将两个通道合并后,FCB 利用 2 维卷积来扩大感受野捕获远距离特征,并使用深度可分离卷积来减少参数和计算量。最后设置了通道混洗操作

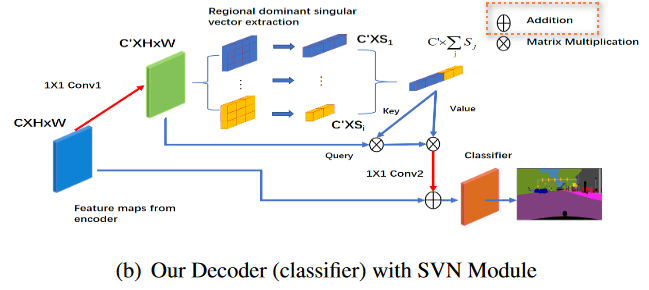

LRNNet 的 SVN 模块?

![LRNNet-20230408152259]()

- 底层分支:来自输入的残余连接

- 上层分支:是简化非局部操作的瓶颈,将特征图划分为空间子区域。利用区域奇异向量产生更有代表性的特征来建模远程依赖和全局特征选择,区域优势奇异向量是特征图区域最具代表性的特征向量

- 上分支构建稀疏注意力的过程 (1) 计算得到 K、V: 特征 通过 1 x 1 卷积将通道调整 C->C’,然后对 HW 的区域分 S 个子区域,对每个子区域大小为 (C‘, H/S, W/S),通过迭代算法将所有子区域简化到 (C’, 1),所有子区域则有 ,即是 K, V;(2) 计算注意力: 通过 得到大小为 注意力矩阵,相比较构建 注意力矩阵,这个举证更小,所以其注意力更加稀疏;(3) 加权特征,注意力矩阵 与 V 点成,得到大小为 的输出,然后通过 1 x 1 卷积得到 的输出,然后和原始特征 相加

- 不考虑 1 x 1 卷积调整通道数,其实就是对空间进行分区域,然后求区域与每个像素的注意力矩阵